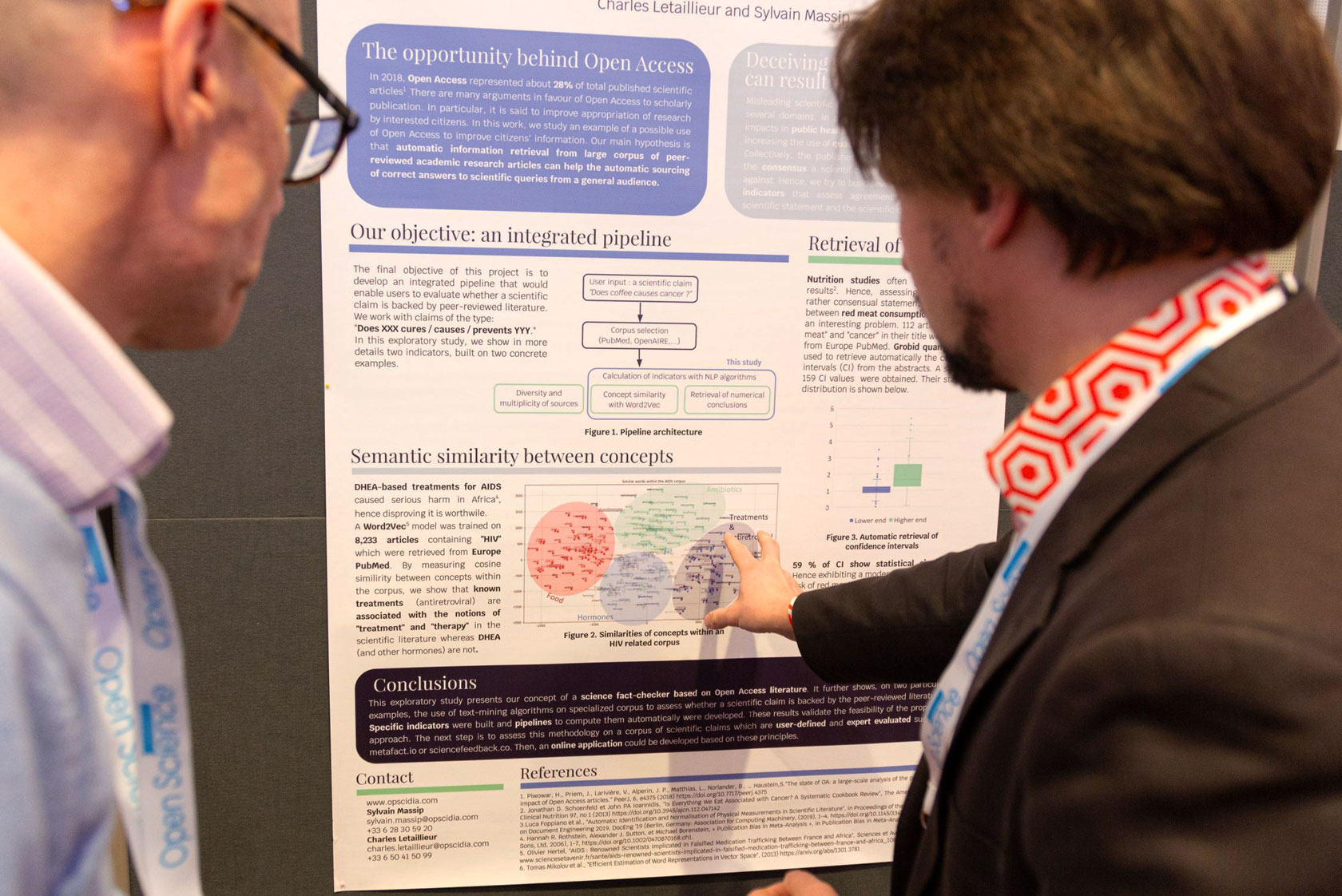

Opscidia: Fake News per Open Access bekämpfen

Fake News haben sich in den letzten Jahren zu einem wachsenden Problem in der internationalen Informationslandschaft entwickelt. Immer mehr Projekte beschäftigen sich damit, wie man sie enttarnen und vermeiden kann. Eines davon ist Opscidia, das Projekt von Charles Letaillieur und Sylvain Massip. Mit einem Tool für die breite Öffentlichkeit möchten die beiden es ermöglichen, einfache Botschaften auf Basis von Open-Access-Publikationen und mithilfe von künstlicher Intelligenz auf ihre Wahrheitswahrscheinlichkeit zu überprüfen.

im Interview mit Charles Letaillieur

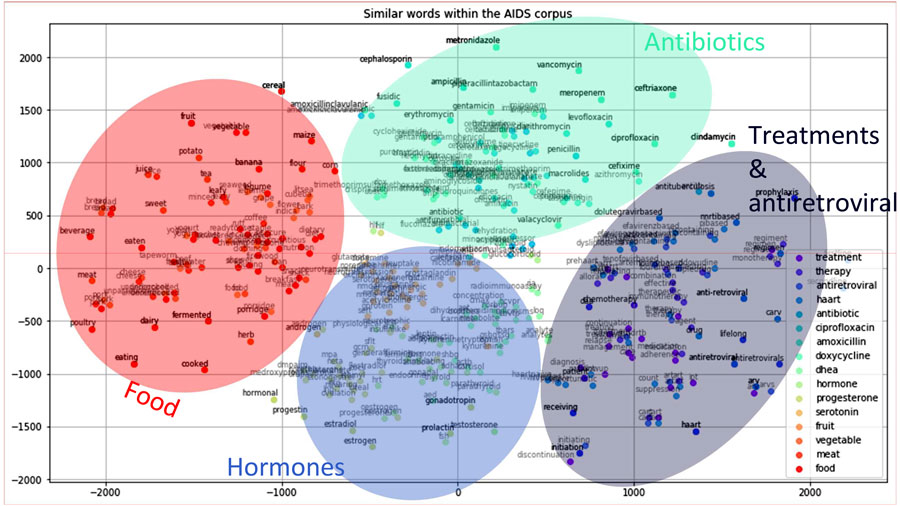

Vor einem Jahr haben Charles Letaillieur und Sylvain Massip Opscidia gegründet, eine kostenlose, Open-Source-basierte Open-Access-Publikationsplattform, die akademische Zeitschriften hostet. Ziel ist es, die Wissenschaft mithilfe von künstlicher Intelligenz und Open-Access-Publikationen besser zu machen, auch, um dadurch Fake News zu bekämpfen. Dazu nutzen sie Methoden des maschinellen Lernens, verarbeiten die natürliche Sprache und verwenden eine spezielle Text-Mining-Pipeline. Auf Basis von Open-Access-Publikationen haben sie ein Tool entwickelt, das feststellen kann, ob eine Behauptung von der wissenschaftlichen Literatur gestützt, diskutiert oder abgelehnt wird. Im Interview verrät uns Charles Letaillieur, wie genau das funktioniert und welches Potenzial er in dem Projekt sieht.

In eurem Projekt geht es auch darum, die Einsatzmöglichkeiten von Open Access außerhalb der Wissenschaft aufzuzeigen. Warum ist das wichtig?

Je mehr Anwendungen es von Open Science und Open Access gibt, umso schneller werden sie sich entwickeln und universell werden. Sobald dann Wirtschaftsakteure, Führungskräfte des öffentlichen Sektors und die breite Öffentlichkeit beginnen, Open Access zu wissenschaftlicher Literatur in hohem Maße zu nutzen, wird die Finanzierung solcher Publikationen einfacher werden, und es werden sich weitere Lösungen abzeichnen.

Darüber hinaus glauben wir, dass Open Science nicht nur ein ideelles Ziel ist, sondern wir wollen, dass es für Menschen und Gesellschaft tatsächlich von Nutzen ist. Um dies zu erreichen, müssen Anwendungen entwickelt werden, die helfen, das in akademischen Artikeln geteilte Wissen wiederzuverwenden.

Wie kann das Open-Access-Publizieren in Kombination mit maschinellem Lernen dazu beitragen, Fake News zu erkennen und zu bekämpfen?

Was auch immer Ihre Meinung zu einem wissenschaftlichen Thema ist, Sie werden eine Expertin oder einen Experten (d.h. jemanden mit akademischer Qualifikation) und einige wissenschaftliche Artikel finden, die Ihre Meinung bestätigen. Dies ist die Schwachstelle einer Suchmaschine wie Google Scholar, deren Ziel es ist, den für Sie relevantesten Artikel auszuwählen.

Die Corona-Krise hat dafür sehr deutliche Beispiele geliefert: Fachleute bekämpfen sich in diesem Kontext zu jedem Thema, von der potenziellen Schwere der Corona-Pandemie bis hin zum Tragen der Maske. Gleichzeitig haben die Kämpfe um die Chloroquin-Artikel und das “Lancet-gate” wieder einmal gezeigt, dass ein einziges Papier nie ausreicht, um eine Debatte zu beenden.

Die einzige Möglichkeit, um sich ein klares Bild vom Stand der Wissenschaft zu machen, besteht deshalb darin, mehrere Artikel zu einem bestimmten Thema zu analysieren. Dies ist jedoch ein langwieriger Prozess, der Forschungskompetenzen und ein relativ tiefes Fachwissen zu dem untersuchten Thema erfordert.

Künstliche Intelligenz kann die Öffentlichkeit in diesem Prozess unterstützen. Unsere Idee ist es, Algorithmen diese Literatur “lesen” zu lassen und sie für Benutzerinnen und Benutzer zusammenzufassen.

Ist es wirklich möglich, eine Text-Mining-Pipeline zu bauen, die anzeigt, ob ein wissenschaftlicher Anspruch durch die wissenschaftliche Literatur gestützt wird. Und wenn ja, wie?

Wir sind der festen Überzeugung, dass es sinnvoll ist, große Mengen an wissenschaftlichen Texten auszuwerten, vorausgesetzt, dass jeder Text ein ausreichendes Qualitätsniveau erreich. Das erreichen zum Beispiel professionell begutachtete veröffentlichte Forschungsarbeiten (peer-reviewed).

Möglichst viele wissenschaftliche Texte auszuwerten ist eines der Hauptanliegen von Opscidia: Es gibt viele gute Forschungsarbeiten, die nicht ausreichend verwertet werden, weil sie nicht auffindbar sind. Daher ist die Analyse eines vollständigen Korpus ein großer Mehrwert gegenüber der einfachen Konsultation der angesehensten Fachleute.

Inspiriert wurde das Projekt ursprünglich durch die Erfahrungen eines Wissenschaftsjournalisten, für den es oft sehr zeitaufwändig ist, die richtige Expertin oder den richtigen Experten für eine bestimmte Thematik zu finden. Unser Science-Checker-Projekt ist nur ein erster Schritt, um Journalisten wie ihm zu helfen!

Um Fake Science aufzudecken, sollte unser Ansatz als eine Ergänzung zur Konsultation von Fachleuten gesehen werden, denn der reine Expertenansatz hat seine Grenzen. Es ist bekannt, dass Menschen immer sehr angesehene Expertinnen und Experten mit vielen Referenzen finden können, die ihre Vorurteile bestätigen. So behauptet beispielsweise ein französischer Nobelpreisträger für Physiologie, dass Impfstoffe schädlich seien. Aber solche Meinungen sind immer eine Minderheit. Deshalb ist es wichtig, die gesamte wissenschaftliche Community zu berücksichtigen.

Es gibt auch historische Beispiele, die diese Annahme untermauern: Am Anfang von Wikipedia glaubte man, dass Wikipedia niemals qualitativ gut sein oder zumindest niemals mit den traditionellen, von Expertinnen und Experten verfassten Enzyklopädien konkurrieren könnte. Heute ist Wikipedia anerkannt, und es ist sogar bestätigt, dass sie sich sehr wohl mit beispielsweise der Encyclopædia Britannica messen kann.

Deswegen möchten wir ein Werkzeug erschaffen, das den Menschen hilft, die wissenschaftliche Literatur zu analysieren, für deren Lektüre sie nicht die Zeit haben. Das ist natürlich etwas anderes, als ihnen die Wahrheit zu sagen!

Unser Ansatz besteht darin, verschiedene Indikatoren zu erstellen, die der Benutzerin oder dem Benutzer helfen, sich ein genaues Bild vom wissenschaftlichen Konsens zu einer bestimmten Frage zu machen. Unser Ziel ist es, der Benutzerin oder dem Benutzer klar zu zeigen, ob eine Behauptung von der wissenschaftlichen Literatur gestützt, diskutiert oder abgelehnt wird, und ihnen eine Bewertung der Vertrauenswürdigkeit dieser Behauptung zu geben.

Wo seht ihr die Grenzen dieses Ansatzes?

Zunächst einmal: Viele Fragen werden von vielen Fachleuten auf beiden Seiten diskutiert. Unsere Rolle besteht nicht darin, solche Debatten beizulegen.

Außerdem kann es bei einer ganz bestimmten Behauptung vorkommen, dass es nicht viele Artikel zu diesem Thema gibt. Unser Ansatz ist statistisch, daher ist er fehleranfälliger, wenn er auf einer kleinen Anzahl von Artikeln basiert.

Je komplexer die zu überprüfende Behauptung ist, desto komplexer das Problem, für das sie steht. Je schwieriger ist sie auch automatisiert mit unserem Tool zu überprüfen. Deshalb konzentrieren wir uns zunächst nur auf einfache Behauptungen dieser Form: Verursacht/heilt/verhindert X Y?

Wie können Bibliotheken euch oder ähnliche Projekte unterstützen?

Indem sie zur Entwicklung des Open-Access-Publizierens beitragen. Es besteht ein großer Bedarf an qualitativ hochwertigen „Orten“ für Open-Access-Publikationen. Wir betreiben einen solchen unter journals.opscidia.com. Es gibt viele andere. Wie gesagt, das Open-Access-Publizieren und seine Anwendungen müssen Hand in Hand entwickelt werden.

Die Zielgruppe eurer Text-Mining-Pipeline ist die Öffentlichkeit. Wäre sie auch für Forschende interessant? Wenn ja, an welchem Punkt im Forschungsprozess?

Ja, sie ist in der Tat für die breite Öffentlichkeit bestimmt. Nichtsdestotrotz könnte es für Forschende nützlich sein, wenn sie versuchen, die Grundlagen eines neuen Gebietes zu verstehen, zum Beispiel für ein transdisziplinäres Projekt. Darüber hinaus sind Wissenschaftlerinnen und Wissenschaftler auch Bürgerinnen und Bürger, und sie könnten daran interessiert sein, Behauptungen zu überprüfen, die sich nicht direkt auf ihre Forschung beziehen, an denen sie aber ein persönliches Interesse haben.

Was würde passieren, wenn euer Tool Fake News entdeckt? Wie transparent sind die Gründe für diese Entscheidung für eure Benutzerinnen und Benutzer?

Unser System ist als Entscheidungshilfe konzipiert. Es ist dazu da, dem Benutzenden zu helfen, entscheidet aber nicht an ihrer/seiner Stelle. Daher muss die Bewertung unseres Systems sehr transparent sein und klar aufzeigen, wie die Ergebnisse zustandekommen.

Das Ergebnis jedes Indikators wird angezeigt, und es wird eine Anleitung geben, die die Indikatoren erklärt und erläutert, warum wir sie für sinnvoll halten. Schließlich wird es Links zu Artikeln geben, sodass die Benutzerin oder der Benutzer die Aussage selbst überprüfen kann.

Plant ihr selbst ein automatisches Faktenprüfungs-Tool oder eine Online-Anwendung zu entwickeln?

Ja, unbedingt. Unser Poster “Leveraging Open Access

publishing to fight fake news” auf der Open Science Konferenz 2020 war ein kurzer Wirksamkeitsnachweis.

Vor kurzem haben wir von der Vietsch-Stiftung einen Zuschuss für die Entwicklung eines Prototyps erhalten.

In dieser ersten Version werden drei Indikatoren verwendet, um die folgenden Fragen zu beantworten:

- Was sind die Quellen? Wird die Behauptung schon lange untersucht? Wird sie aktuell noch diskutiert? Wird sie in vielen Institutionen in vielen Ländern umfassend untersucht?

- Ist die Behauptung nach einer breiten Analyse themenbezogener Artikel wahrscheinlich?

- Wird die Behauptung durch eine Vielzahl von Artikeln untermauert?

Um den Umfang des Projekts einzuschränken, wird sich diese erste Version des Tools auf Gesundheitsthemen konzentrieren und auf vordefinierten Fragen basieren. Unsere Test-Website für das Projekt zeigt Beispiele für die Art von Indikatoren, die wir auch in der finalen Version sehen werden.

Ist es möglich euren Ansatz zu erweitern, zum Beispiel durch die Verifizierung von frei verfügbaren Forschungsdaten, die einer Publikation beigefügt sind?

Es wird mehrere Möglichkeiten geben, unseren Ansatz über diesen Prototypen hinaus zu erweitern. Erstens, indem wir neue Quellen hinzufügen. Wir werden die Zusammenarbeit mit Europe PubMed aufnehmen. Zweitens, indem wir komplexere Aussagen zulassen als diejenigen, die wir für unseren Prototypen entwickeln.

Tatsächlich wäre es eine weitere große Verbesserung, wenn wir auch andere Medien wie Forschungsdaten berücksichtigen würden. Wir werden sicherlich irgendwann einmal einen Blick darauf werfen, aber zunächst werden wir unseren Schwerpunkt auf Artikel legen.

Charles Letaillieur ist ein Web- und Tech-Profi mit mehr als zwölf Jahren Erfahrung in der Entwicklung von disruptiven Produkten rund um die Openness-Bewegung (OpenData, OpenGov). Vor etwa einem Jahr hat er zusammen mit Sylvain Massip Opscidia gegründet. Ihr Ziel ist es, die Wissenschaft mithilfe künstlicher Intelligenz und Open-Access-Publikationen zu verbessern.

Das Copyright der Fotos liegt bei Ralf Rebmann, Chloé Lafortune und Charles Letaillieur.

View Comments

Open-Science-Training: Erfolgreich in europäische Forschungsbibliotheken implementieren

Wie lassen sich die Prinzipien von Open Science in europäischen...